Spark программа что это

Что такое Apache Spark?

Apache Spark — это платформа параллельной обработки с открытым кодом, которая поддерживает обработку в памяти, чтобы повысить производительность приложений, анализирующих большие данные. Решения для работы с большими данными предназначены для обработки данных со слишком большим объемом или сложностью для традиционных баз данных. Spark обрабатывает большие объемы данных в памяти, что намного быстрее, чем альтернативная обработка с использованием диска.

Типичные сценарии обработки больших данных

Следует предусмотреть архитектуру для работы с большими данными, если вам нужно хранить и обрабатывать большие объемы данных, преобразовывать неструктурированные или обрабатывать потоковые данные. Spark предоставляет механизм распределенной обработки широкого назначения, который позволяет реализовать несколько сценариев работы с большими данными.

Извлечение, преобразование и загрузка (ETL)

Процесс извлечения, преобразования и загрузки (ETL) включает сбор данных из одного или нескольких источников, изменение этих данных и их перемещение в новое хранилище. Есть несколько способов преобразовать данные, например:

Обработка потоков данных в реальном времени

Данными потоковой передачи (реального времени) называют данные, которые находятся в движении. К ним относятся, например, данные телеметрии от устройств Интернета вещей, веб-журналы и сведения о посещении ресурсов. Обработка данных реального времени позволяет получить полезные сведения (например, с помощью геопространственного анализа, удаленного мониторинга и обнаружения аномалий). Как и в случае с реляционными данными, перед перемещением потоковых данных в приемник вы можете их фильтровать, объединять и подготавливать. Apache Spark поддерживает обработку потока данных реального времени с помощью потоковой передачи Spark.

Пакетная обработка

Пакетная обработка — это обработка неактивных больших данных. Вы можете фильтровать, объединять и подготавливать очень большие наборы данных с помощью длительно выполняющихся параллельных заданий.

Машинное обучение с использованием MLlib

Машинное обучение позволяет выполнять расширенные аналитические задачи. Ваш компьютер может использовать существующие данные для прогнозирования реакции, результатов и тенденций. Библиотека машинного обучения MLlib из Apache Spark содержит несколько алгоритмов машинного обучения и служебных программ.

Обработка графов с помощью GraphX

Граф — это коллекция узлов, которые соединяются ребрами. Вы можете использовать базу данных графов для иерархических или взаимосвязанных данных. Такие данные можно обрабатывать с помощью API GraphX в Apache Spark.

Обработка SQL и структурированных данных с помощью Spark SQL

Для работы со структурированными (форматированными) данными в приложении Spark можно использовать SQL-запросы с помощью Spark SQL.

Архитектура Apache Spark

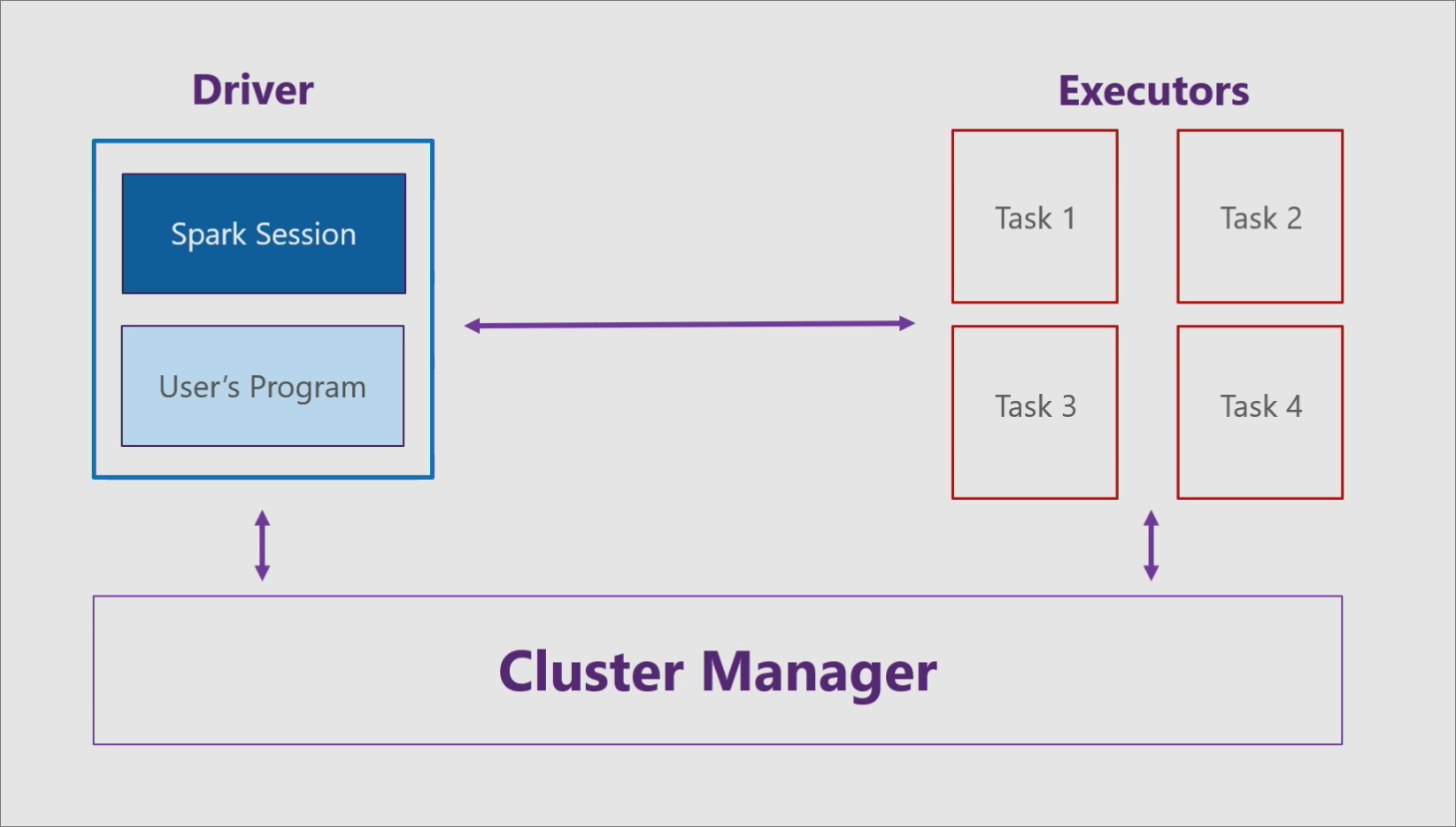

Для Apache Spark при использовании архитектуры «основной-рабочий», предусмотрено три основных компонента: драйвер, исполнители и диспетчер кластера.

Драйвер

Драйвер состоит из пользовательской программы, например консольного приложения C#, и сеанса Spark. Сеанс Spark принимает программу и делит ее на небольшие задачи, которые обрабатываются исполнителями.

Исполнители

Каждый исполнитель (рабочий узел) получает от драйвера задачу и выполняет ее. Исполнители находятся в сущности, которая называется кластером.

Диспетчер кластера

Диспетчер кластера взаимодействует с драйвером и исполнителями, выполняя следующие задачи:

Поддержка языков

Apache Spark поддерживает следующие языки программирования:

API-интерфейсы Spark

Apache Spark поддерживает следующие API:

Дальнейшие действия

Знакомство с Apache Spark

Здравствуйте, уважаемые читатели!

Мы наконец-то приступаем к переводу серьезной книги о фреймворке Spark:

Сегодня мы предлагаем вашему вниманию перевод обзорной статьи о возможностях Spark, которую, полагаем, можно с полным правом назвать слегка потрясающей.

Я впервые услышал о Spark в конце 2013 года, когда заинтересовался Scala – именно на этом языке написан Spark. Несколько позже я принялся ради интереса разрабатывать проект из области Data Science, посвященный прогнозированию выживаемости пассажиров «Титаника». Оказалось, это отличный способ познакомиться с программированием на Spark и его концепциями. Настоятельно рекомендую познакомиться с ним всем начинающим Spark-разработчикам.

Сегодня Spark применяется во многих крупнейших компаниях, таких, как Amazon, eBay и Yahoo! Многие организации эксплуатируют Spark в кластерах, включающих тысячи узлов. Согласно FAQ по Spark, в крупнейшем из таких кластеров насчитывается более 8000 узлов. Действительно, Spark – такая технология, которую стоит взять на заметку и изучить.

В этой статье предлагается знакомство со Spark, приводятся примеры использования и образцы кода.

Что такое Apache Spark? Введение

Spark – это проект Apache, который позиционируется как инструмент для «молниеносных кластерных вычислений». Проект разрабатывается процветающим свободным сообществом, в настоящий момент является наиболее активным из проектов Apache.

Spark предоставляет быструю и универсальную платформу для обработки данных. По сравнению с Hadoop Spark ускоряет работу программ в памяти более чем в 100 раз, а на диске – более чем в 10 раз.

Кроме того, код на Spark пишется быстрее, поскольку здесь в вашем распоряжении будет более 80 высокоуровневых операторов. Чтобы оценить это, давайте рассмотрим аналог “Hello World!” из мира BigData: пример с подсчетом слов (Word Count). Программа, написанная на Java для MapReduce, содержала бы около 50 строк кода, а на Spark (Scala) нам потребуется всего лишь:

При изучении Apache Spark стоит отметить еще один немаловажный аспект: здесь предоставляется готовая интерактивная оболочка (REPL). При помощи REPL можно протестировать результат выполнения каждой строки кода без необходимости сначала программировать и выполнять все задание целиком. Поэтому написать готовый код удается гораздо быстрее, кроме того, обеспечивается ситуативный анализ данных.

Кроме того, Spark имеет следующие ключевые черты:

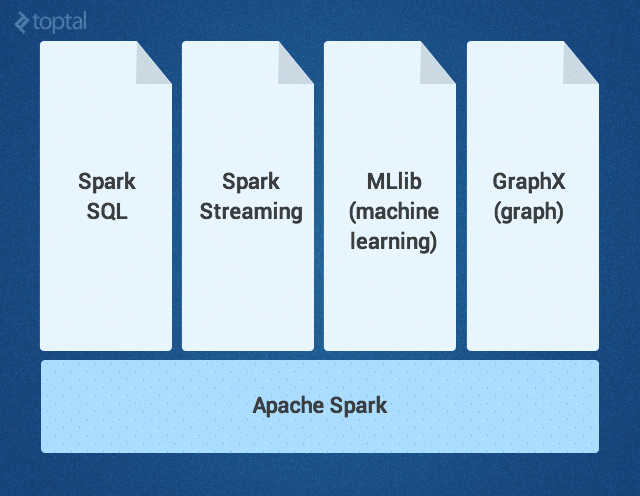

Ядро Spark дополняется набором мощных высокоуровневых библиотек, которые бесшовно стыкуются с ним в рамках того же приложения. В настоящее время к таким библиотекам относятся SparkSQL, Spark Streaming, MLlib (для машинного обучения) и GraphX – все они будут подробно рассмотрены в этой статье. Сейчас также разрабатываются другие библиотеки и расширения Spark.

Ядро Spark

Ядро Spark – это базовый движок для крупномасштабной параллельной и распределенной обработки данных. Ядро отвечает за:

Трансформации в Spark осуществляются в «ленивом» режиме — то есть, результат не вычисляется сразу после трансформации. Вместо этого они просто «запоминают» операцию, которую следует произвести, и набор данных (напр., файл), над которым нужно совершить операцию. Вычисление трансформаций происходит только тогда, когда вызывается действие, и его результат возвращается основной программе. Благодаря такому дизайну повышается эффективность Spark. Например, если большой файл был преобразован различными способами и передан первому действию, то Spark обработает и вернет результат лишь для первой строки, а не станет прорабатывать таким образом весь файл.

По умолчанию каждый трансформированный RDD может перевычисляться всякий раз, когда вы выполняете над ним новое действие. Однако RDD также можно долговременно хранить в памяти, используя для этого метод хранения или кэширования; в таком случае Spark будет держать нужные элементы на кластере, и вы сможете запрашивать их гораздо быстрее.

SparkSQL – это компонент Spark, поддерживающий запрашивание данных либо при помощи SQL, либо посредством Hive Query Language. Библиотека возникла как порт Apache Hive для работы поверх Spark (вместо MapReduce), а сейчас уже интегрирована со стеком Spark. Она не только обеспечивает поддержку различных источников данных, но и позволяет переплетать SQL-запросы с трансформациями кода; получается очень мощный инструмент. Ниже приведен пример Hive-совместимого запроса:

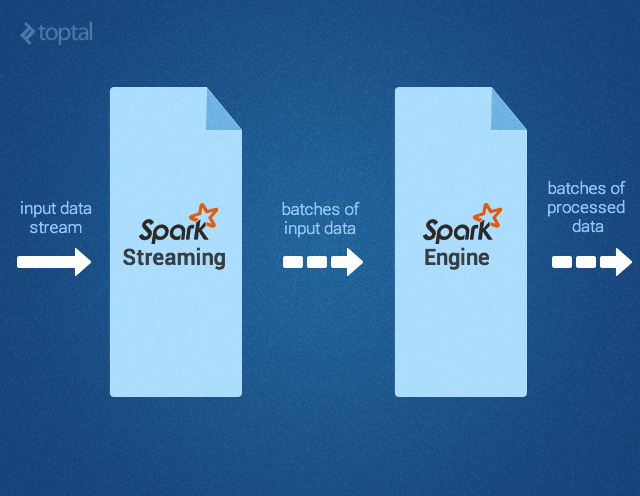

Spark Streaming поддерживает обработку потоковых данных в реальном времени; такими данными могут быть файлы логов рабочего веб-сервера (напр. Apache Flume и HDFS/S3), информация из соцсетей, например, Twitter, а также различные очереди сообщений вроде Kafka. «Под капотом» Spark Streaming получает входные потоки данных и разбивает данные на пакеты. Далее они обрабатываются движком Spark, после чего генерируется конечный поток данных (также в пакетной форме) как показано ниже.

API Spark Streaming точно соответствует API Spark Core, поэтому программисты без труда могут одновременно работать и с пакетными, и с потоковыми данными.

MLlib – это библиотека для машинного обучения, предоставляющая различные алгоритмы, разработанные для горизонтального масштабирования на кластере в целях классификации, регрессии, кластеризации, совместной фильтрации и т.д. Некоторые из этих алгоритмов работают и с потоковыми данными — например, линейная регрессия с использованием обычного метода наименьших квадратов или кластеризация по методу k-средних (список вскоре расширится). Apache Mahout (библиотека машинного обучения для Hadoop) уже ушла от MapReduce, теперь ее разработка ведется совместно с Spark MLlib.

GraphX – это библиотека для манипуляций над графами и выполнения с ними параллельных операций. Библиотека предоставляет универсальный инструмент для ETL, исследовательского анализа и итерационных вычислений на основе графов. Кроме встроенных операций для манипуляций над графами здесь также предоставляется библиотека обычных алгоритмов для работы с графами, например, PageRank.

Как использовать Apache Spark: пример с обнаружением событий

Теперь, когда мы разобрались, что такое Apache Spark, давайте подумаем, какие задачи и проблемы будут решаться с его помощью наиболее эффективно.

Недавно мне попалась статья об эксперименте по регистрации землетрясений путем анализа потока Twitter. Кстати, в статье было продемонстрировано, что этот метод позволяет узнать о землетрясении более оперативно, чем по сводкам Японского Метеорологического Агентства. Хотя технология, описанная в статье, и не похожа на Spark, этот пример кажется мне интересным именно в контексте Spark: он показывает, как можно работать с упрощенными фрагментами кода и без кода-клея.

Во-первых, потребуется отфильтровать те твиты, которые кажутся нам релевантными – например, с упоминанием «землетрясения» или «толчков». Это можно легко сделать при помощи Spark Streaming, вот так:

Затем нам потребуется произвести определенный семантический анализ твитов, чтобы определить, актуальны ли те толчки, о которых в них говорится. Вероятно, такие твиты, как «Землетрясение!» или «Сейчас трясет» будут считаться положительными результатами, а «Я на сейсмологической конференции» или «Вчера ужасно трясло» — отрицательными. Авторы статьи использовали для этой цели метод опорных векторов (SVM). Мы поступим также, только реализуем еще и потоковую версию. Полученный в результате образец кода из MLlib выглядел бы примерно так:

Если процент верных прогнозов в данной модели нас устраивает, мы можем переходить к следующему этапу: реагировать на обнаруженное землетрясение. Для этого нам потребуется определенное число (плотность) положительных твитов, полученных в определенный промежуток времени (как показано в статье). Обратите внимание: если твиты сопровождаются геолокационной информацией, то мы сможем определить и координаты землетрясения. Вооружившись этими знаниями, мы можем воспользоваться SparkSQL и запросить имеющуюся таблицу Hive (где хранятся данные о пользователях, желающих получать уведомления о землетрясениях), извлечь их электронные адреса и разослать им персонализированные предупреждения, вот так:

Другие варианты использования Apache Spark

Потенциально сфера применения Spark, разумеется, далеко не ограничивается сейсмологией.

Вот ориентировочная (то есть, ни в коем случае не исчерпывающая) подборка других практических ситуаций, где требуется скоростная, разноплановая и объемная обработка больших данных, для которой столь хорошо подходит Spark:

В игровой индустрии: обработка и обнаружение закономерностей, описывающих игровые события, поступающие сплошным потоком в реальном времени; в результате мы можем немедленно на них реагировать и делать на этом хорошие деньги, применяя удержание игроков, целевую рекламу, автокоррекцию уровня сложности и т.д.

В электронной коммерции информация о транзакциях, поступающая в реальном времени, может передаваться в потоковый алгоритм кластеризации, например, по k-средним или подвергаться совместной фильтрации, как в случае ALS. Затем результаты даже можно комбинировать с информацией из других неструктутрированных источников данных — например, с отзывами покупателей или рецензиями. Постепенно эту информацию можно применять для совершенствования рекомендаций с учетом новых тенденций.

В финансовой сфере или при обеспечении безопасности стек Spark может применяться для обнаружения мошенничества или вторжений, либо для аутентификации с учетом анализа рисков. Таким образом можно получать первоклассные результаты, собирая огромные объемы архивированных логов, комбинируя их с внешними источниками данных, например, с информацией об утечках данных или о взломанных аккаунтах (см., например, https://haveibeenpwned.com/), а также использовать информацию о соединениях/запросах, ориентируясь, например, на геолокацию по IP или на данные о времени

Итак, Spark помогает упростить нетривиальные задачи, связанные с большой вычислительной нагрузкой, обработкой больших объемов данных (как в реальном времени, так и архивированных), как структурированных, так и неструктурированных. Spark обеспечивает бесшовную интеграцию сложных возможностей – например, машинного обучения и алгоритмов для работы с графами. Spark несет обработку Big Data в массы. Попробуйте – не пожалеете!

Spark

Описание термина: Apache Spark или просто Spark — это фреймворк (ПО, объединяющее готовые компоненты большого программного проекта), который используют для параллельной обработки неструктурированных или слабоструктурированных данных.

Например, если нужно обработать данные о годовых продажах одного магазина, то программисту хватит одного компьютера и кода на Python, чтобы произвести расчет. Но если обрабатываются данные от тысяч магазинов из нескольких стран, причем они поступают в реальном времени, содержат пропуски, повторы, ошибки, тогда стоит использовать мощности нескольких компьютеров и Spark. Группа компьютеров, одновременно обрабатывающая данные, называется кластером, поэтому Spark также называют фреймворком для кластерных вычислений.

Зачем нужен Spark

Области использования Spark — это Big Data и технологии машинного обучения, поэтому им пользуются специалисты, работающие с данными, например дата-инженеры, дата-сайентисты и аналитики данных.

Примеры задач, которые можно решить с помощью Spark:

Spark поддерживает языки программирования Scala, Java, Python, R и SQL. Сначала популярными были только первые два, так как на Scala фреймворк был написан, а на Java позже была дописана часть кода. С ростом Python-сообщества этим языком тоже стали пользоваться активнее, правда обновления и новые фичи в первую очередь доступны для Scala-разработчиков. Реже всего для работы со Spark используют язык R.

Data Scientist с нуля

Всего за год вы получите перспективную профессию, пополните портфолио рекомендательной системой и нейросетями, примете участие в соревнованиях на Kaggle и в хакатонах.

В структуру Spark входят ядро для обработки данных и набор расширений:

Как работает Spark

Спарк интегрирован в Hadoop — экосистему инструментов с открытым доступом, в которую входят библиотеки, система управления кластером (Yet Another Resource Negotiator), технология хранения файлов на различных серверах (Hadoop Distributed File System) и система вычислений MapReduce. Классическую модель Hadoop MapReduce и Spark постоянно сравнивают, когда речь заходит об обработке больших данных.

Принципиальные отличия Spark и MapReduce

Пакетная обработка данных

Хранит данные на диске

В 100 раз быстрее, чем MapReduce

Обработка данных в реальном времени

Хранит данные в оперативной памяти

Пакетная обработка в MapReduce проходит на нескольких компьютерах (их также называют узлами) в два этапа: на первом головной узел обрабатывает данные и распределяет их между рабочими узлами, на втором рабочие узлы сворачивают данные и отправляют обратно в головной. Второй шаг пакетной обработки не начнется, пока не завершится первый.

Читайте также: Какой язык учить аналитику данных?

Обработка данных в реальном времени с помощью Spark Streaming — это переход на микропакетный принцип, когда данные постоянно обрабатываются небольшими группами.

Кроме этого, вычисления MapReduce производятся на диске, а Spark производит их в оперативной памяти, и за счет этого его производительность возрастает в 100 раз. Однако специалисты предупреждают, что заявленная «молниеносная скорость работы» Spark не всегда способна решить задачу. Если потребуется обработать больше 10 Тб данных, классический MapReduce доведет вычисление до конца, а вот у Spark может не хватить памяти для такого вычисления.

Но даже сбой в работе кластера не спровоцирует потерю данных. Основу Spark составляют устойчивые распределенные наборы данных (Resilient Distributed Dataset, RDD). Это значит, что каждый датасет хранится на нескольких узлах одновременно и это защищает весь массив.

Освойте самую перспективную профессию 2021 года. После обучения вы будете обладать навыками middle-специалиста и рассчитывать на среднюю зарплату по отрасли.

Разработчики говорят, что до выхода версии Spark 2.0 платформа работала нестабильно, постоянно падала, ей не хватало памяти, и проблемы решались многочисленными обновлениями. Но в 2021 году специалисты уже не сталкиваются с этим, а обновления в основном направлены на расширение функционала и поддержку новых языков.

✅ «Наша компания использует Spark для прогнозирования финансовых рисков»

❌ «Я учусь работать в программе Spark»

Тонкая настройка IM-клиента Spark

Мы у себя в сети несколько лет успешно и стабильно используем связку OpenFire + Spark с 200 активными пользователями (с учетом удаленных подключений). IM-клиент Spark принят в качестве корпоративного стандарта для системы мгновенного обмена сообщениями. Не вдаваясь в причины выбора, хочу поделится тонкостями его настройки для конечного пользователя. Процесс будет описан на примере установленного пакета Spark 2.7.0 для ОС Windows 7.

В установленном каталоге находим файл spark.jar (C:/Program Files/Spark/lib/spark.jar), открываем его любым архиватором (IzArc), далее любым текстовым редактором (Notepad++) открываем файл «spark.jar/org/jivesoftware/resource/default.properties». Необходимо учесть, что файл «spark.jar» перезаписывается после каждой переустановки или обновлении IM-клиента Spark, поэтому его необходимо снова заменить (при переустановке) или сделать новый (в случае смены версии) на компьютерах всех своих пользователей. Итак, приступим…

Раздел «Окно приглашения»

# изменения стартового изображения и название приложения

# размер изображения должен быть 244х188 пикселя

MAIN_IMAGE = images/spark.gif

APPLICATION_NAME = Spark

# указываем фиксированное имя сервера

HOST_NAME = SRV5-VM1

# установка значения «true» запретит пользователям изменить имя сервера

HOST_NAME_CHANGE_DISABLED = true

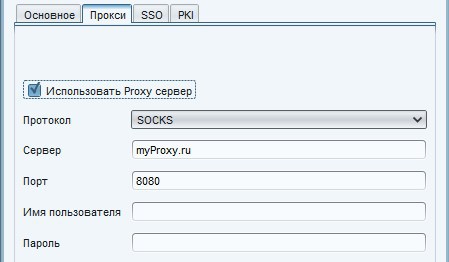

# настройки Proxy, доступные протоколы HTTP или SOCKS, чувствительны к регистру.

PROXY_PROTOCOL = SOCKS

PROXY_HOST = myProxy.ru

PROXY_PORT = 8080

# удаление кнопки создания учетной записи с формы загрузки

# пользователи не смогут создавать новый учетные записи в Spark

ACCOUNT_DISABLED = true

# удаление кнопки дополнительных настроек с формы загрузки

# пользователи не будут иметь доступ к дополнительным настройкам

ADVANCED_DISABLED = true

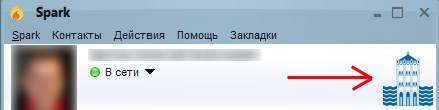

# добавление логотипа компании, он будет отображается в правом верхнем углу основного окна

# изображение должно быть размещено в папке src/resource/images, путь должен быть «images/file.jpg» или «images/file.png»

BRANDED_IMAGE = images/our-logo.png

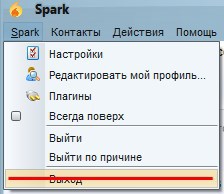

# можно отключить возможность обновления

DISABLE_UPDATES = true

# отключаем возможность закрытия Spark

DISABLE_EXIT = true

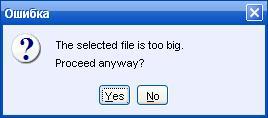

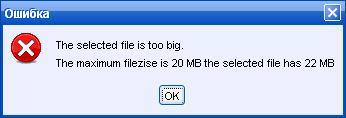

Раздел «Передача файлов»

# определяем максимальный размер файла, который пользователь может отправить

FILE_TRANSFER_MAXIMUM_SIZE = 20971520

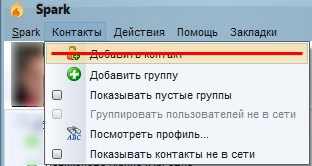

Раздел «Settings Window»

# отключаем возможность добавления контактов в Spark

ADD_CONTACT_DISABLED = true

# отключаем возможность добавления групп в Spark

ADD_CONTACT_GROUP_DISABLED = true

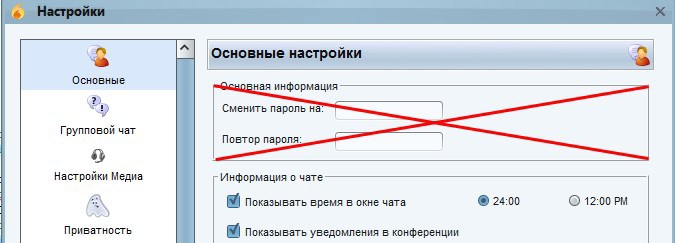

# запретить пользователю менять пароль

CHANGE_PASSWORD_DISABLED = true

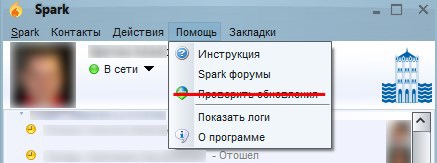

# расположение руководства пользователя, по-умолчанию www.igniterealtime.org/builds/spark/docs/spark_user_guide.pdf

HELP_USER_GUIDE = ссылка на руководство пользователя на корпоративном сайте

# отображать меню руководства пользователя или нет

HELP_USER_GUIDE_DISABLED =

# расположение форума помощи, по-умолчанию www.igniterealtime.org/forum/forum.jspa?forumID=49

HELP_FORUM = ссылка на форум помощи на корпоративном сайте

# отображать меню форума помощи или нет

HELP_FORUM_DISABLED =

# следующий текст будет отображаться вместо «Spark forum»

# если оставить пустым, значение будет по-умолчанию

HELP_FORUM_TEXT =

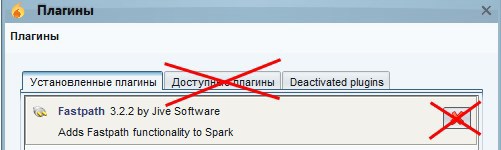

# отключение возможности установки плагинов

INSTALL_PLUGINS_DISABLED = true

# отключение возможности удаления плагинов

DEINSTALL_PLUGINS_DISABLED = true

# для того чтобы сделать плагин(ы) недоступным(и), укажите названия через запятую, написание чувствительно к регистру.

# названия плагинов можно найти в файле «plugin.xml»

# например: Fastpath,Jingle Client,Phone Client,Window Flashing Plugin

# значение по-умолчанию пустое

PLUGIN_BLACKLIST = Fastpath

# для того чтобы сделать плагин(ы) недоступным(и) с помощью классов, укажите их названия через запятую, написание чувствительно к регистру.

# например: org.jivesoftware.fastpath.FastpathPlugin

# значение по-умолчанию пустое

PLUGIN_BLACKLIST_CLASS = org.jivesoftware.spark.translator.TranslatorPlugin

Два последних пункта полностью сделают недоступным все плагины с именем Fastpath и все плагины с org.jivesoftware.spark.translator.TranslatorPlugin.

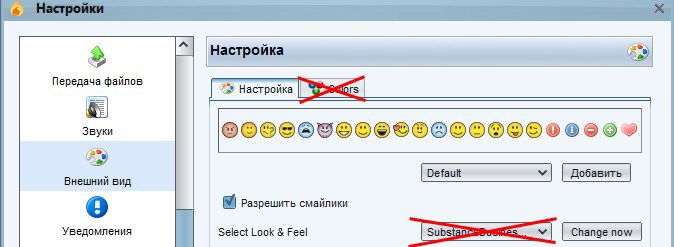

Раздел «Цвета и Внешний вид»

# по-умолчанию, сервер рассылок получает свой собственный JFrame, который содержит сообщение

# при этом могут использоваться HTML-тэги для жирного, наклонного или подчеркнутого текста

# если вы хотите чтобы сообщения рассылки выглядели как остальные сообщения, установите значение «true»

BROADCAST_IN_CHATWINDOW = true

# сделать недоступным изменение внешнего вида

# изменить настройки внешнего вида можно в «Настройки»->«Внешний вид»

LOOK_AND_FEEL_DISABLED = true

# сделать недоступным изменение цветов

# изменить настройки цветов можно в «Настройки»->«Внешний вид»->«Цвета»

CHANGE_COLORS_DISABLED = true

# изменение внешнего вида, по-умолчанию внешний вид SubstanceBusinessBlueSteelLookAndFeel

DEFAULT_LOOK_AND_FEEL = com.jtattoo.plaf.luna.LunaLookAndFeel

# установка текста выпадающего меню, работает только при установке внешних видов JTattoo

MENUBAR_TEXT = «Название компании»