Udimm что это такое

Русские Блоги

Разница между памятью UDIMM, LRDIMM и RDIMM

В настоящее время используются три основных типа модулей памяти (DIMM): UDIMM, RDIMM и LRDIMM.

UDIMM

Когда данные передаются от ЦП к каждой частице памяти, UDIMM должен обеспечивать равное расстояние передачи между ЦП и каждой частицей памяти, чтобы параллельная передача была эффективной, а это требует более сложного производственного процесса. Следовательно, UDIMM имеет как емкость, так и частоту. Нижняя.

RDIMM

RDIMM: полное имя Registered DIMM, модуль памяти с двумя линиями и регистром. RDIMM добавляет регистр к полосе памяти для передачи, который расположен между ЦП и частицами памяти, что не только сокращает расстояние параллельной передачи, но также обеспечивает эффективность параллельной передачи. Благодаря высокой эффективности регистра емкость и частоту RDIMM легче увеличить по сравнению с UDIMM.

LRDIMM

Кроме того, память LRDIMM заменяет микросхему регистра в памяти RDIMM на микросхему изолированного буфера памяти iMB (буфер памяти изоляции). Прямым преимуществом является уменьшение нагрузки на шину памяти и дальнейшее увеличение поддерживаемой емкости памяти.

Отличие и применение

Поскольку UDIMM не использует регистры, буферизация не требуется, а задержка мала при той же частоте. Кроме того, еще одно преимущество UDIMM заключается в его невысокой цене. Недостаток в том, что емкость и частота невелики, емкость до 4 ГБ, а частота до 2133 МТ / с. Кроме того, поскольку модули UDIMM могут работать только в небуферизованном режиме и не поддерживают полное выделение памяти сервера (максимальную емкость), производительность сервера не может быть максимальной. В сценариях приложений UDIMM можно использовать не только в области серверов, но и на рынке настольных компьютеров.

Можно сказать, что LRDIMM заменяет RDIMM. С одной стороны, он снижает нагрузку и энергопотребление шины памяти, а с другой стороны, обеспечивает максимальную поддерживаемую емкость памяти. Хотя его самая высокая частота такая же, как у RDIMM, оба они составляют 3200 МТ / с, но Емкость увеличена до 64 ГБ. И, по сравнению с RDIMM, двухранговая память LRDIMM потребляет только 50% потребляемой мощности. LRDIMM также поставляется в серверной области, но его цена выше, чем у RDIMM.

Чтобы более интуитивно понять разницу между этими тремя, редактор Tianxia Data сделал простую сравнительную таблицу в конце статьи.

Разница между серверной памятью UDIMM и RDIMM

Table of Contents:

СОДИММ против UDIMM: в чем разница? Кредит: tonphai / iStock / Getty Images

UDIMM

Модуль буферизованной памяти использует микропроцессор для передачи данных перед тем, как перейти к или из микросхем памяти модуля. Это позволяет компьютеру устанавливать множество модулей памяти, не перегружая контроллер памяти материнской платы и не вызывая нестабильность системы. Многие компьютеры с более чем четырьмя слотами требуют буферизованной памяти. Ноутбуки и обычные настольные компьютеры имеют максимум четыре слота памяти и поэтому не требуют буферизованной памяти. В результате на большинстве компьютеров установлены UDIMM.

SO-DIMM

В ноутбуках и настольных компьютерах малого форм-фактора больше места, что затрудняет поиск места для полноразмерных модулей памяти. В результате на этих компьютерах используются модули памяти с меньшими печатными платами. Модули SO-DIMM позволяют небольшому компьютеру иметь объем памяти, сопоставимый с полноразмерными компьютерами.

Идентификация SO-DIMM

Вы можете идентифицировать SO-DIMM прежде всего по размеру; стандартный модуль DIMM имеет длину чуть более пяти дюймов, а модуль SO-DIMM имеет длину чуть более 2,5 дюймов. DDR3-SDRAM SO-DIMM имеет 204 контакта, а DDR3-SDRAM DIMM имеет 240 контактов.

Идентификация UDIMM

DIMM без буферизации может быть либо полноразмерным DIMM, либо SO-DIMM. Поскольку буферизованная память необходима только для серверов и компьютеров рабочих станций, все SO-DIMM являются UDIMM. Кроме того, большинство полноразмерных модулей DIMM являются UDIMM. У UDIMM отсутствует микропроцессор, присутствующий в середине буферизованных модулей памяти.

СОДИММ против SDRAM

Asus lyra против Asus Lyra Trio против Asus Lyra Mini: цена, производительность и возможности!

Сравнивая ASUS Lyra AC2200, с ASUS Lyra Mini и ASUS Lyra Trio. Чем они одинаковы и чем отличаются между этими моделями? Какой из них вы должны купить?

Apple iphone 4s против Motorola Razr против Samsung Galaxy Nexus: все

Покупаете телефон на праздники? Вот как складываются Apple iPhone 4S, Motorola DROID RAZR и Samsung Galaxy Nexus. Motorola RAZR Galaxy Nexus

Память ноутбука so dimm ddr3 в компьютер / Обзор переходников с Aliexpress / SODIMM в DDR3 (Декабрь 2021).

Про ранги и виртуализацию в RAM

В продолжение рубрики «конспект админа» хотелось бы разобраться в нюансах технологий ОЗУ современного железа: в регистровой памяти, рангах, банках памяти и прочем. Подробнее коснемся надежности хранения данных в памяти и тех технологий, которые несчетное число раз на дню избавляют администраторов от печалей BSOD.

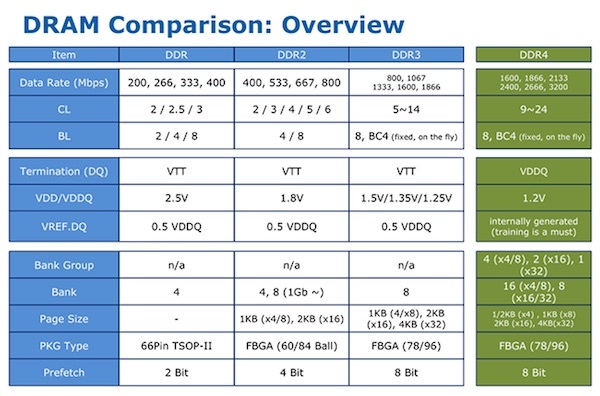

Старые песни про новые типы

Сегодня на рынке представлены, в основном, модули с памятью DDR SDRAM: DDR2, DDR3, DDR4. Разные поколения отличаются между собой рядом характеристик – в целом, каждое следующее поколение «быстрее, выше, сильнее», а для любознательных вот табличка:

Для подбора правильной памяти больший интерес представляют сами модули:

RDIMM — регистровая (буферизованная) память. Удобна для установки большого объема оперативной памяти по сравнению с небуферизованными модулями. Из минусов – более низкая производительность;

UDIMM (unregistered DRAM) — нерегистровая или небуферизованная память — это оперативная память, которая не содержит никаких буферов или регистров;

LRDIMM — эти модули обеспечивают более высокие скорости при большей емкости по сравнению с двухранговыми или четырехранговыми модулями RDIMM, за счёт использования дополнительных микросхем буфера памяти;

HDIMM (HyperCloud DIMM, HCDIMM) — модули с виртуальными рангами, которые имеют большую плотность и обеспечивают более высокую скорость работы. Например, 4 физических ранга в таких модулях могут быть представлены для контроллера как 2 виртуальных;

Попытка одновременно использовать эти типы может вызвать самые разные печальные последствия, вплоть до порчи материнской платы или самой памяти. Но возможно использование одного типа модулей с разными характеристиками, так как они обратно совместимы по тактовой частоте. Правда, итоговая частота работы подсистемы памяти будет ограничена возможностями самого медленного модуля или контроллера памяти.

Для всех типов памяти SDRAM есть общий набор базовых характеристик, влияющий на объем и производительность:

частота и режим работы;

Конечно, отличий на самом деле больше, но для сборки правильно работающей системы можно ограничиться этими.

Частота и режим работы

Понятно, что чем выше частота — тем выше общая производительность памяти. Но память все равно не будет работать быстрее, чем ей позволяет контроллер на материнской плате. Кроме того, все современные модули умеют работать в в многоканальном режиме, который увеличивает общую производительность до четырех раз.

Режимы работы можно условно разделить на четыре группы:

Single Mode — одноканальный или ассиметричный. Включается, когда в системе установлен только один модуль памяти или все модули отличаются друг от друга. Фактически, означает отсутствие многоканального доступа;

Dual Mode — двухканальный или симметричный. Слоты памяти группируются по каналам, в каждом из которых устанавливается одинаковый объем памяти. Это позволяет увеличить скорость работы на 5-10 % в играх, и до 70 % в тяжелых графических приложениях. Модули памяти необходимо устанавливать парами на разные каналы. Производители материнских плат обычно выделяют парные слоты одним цветом;

Triple Mode — трехканальный режим работы. Модули устанавливаются группами по три штуки — на каждый из трех каналов. Аналогично работают и последующие режимы: четырехканальные (quad-channel), восьмиканальные (8-channel memory) и т.п.

Для максимального быстродействия лучше устанавливать одинаковые модули с максимально возможной для системы частотой. При этом используйте установку парами или группами — в зависимости от доступного многоканального режима работы.

Ранги для памяти

Ранг (rank) — область памяти из нескольких чипов памяти в 64 бита (72 бита при наличии ECC, о чем поговорим позже). В зависимости от конструкции модуль может содержать один, два или четыре ранга.

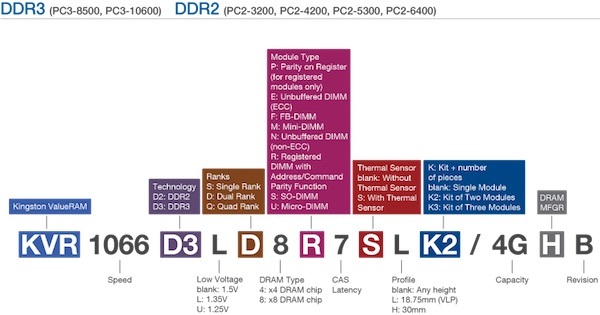

Узнать этот параметр можно из маркировки на модуле памяти. Например уKingston число рангов легко вычислить по одной из трех букв в середине маркировки: S (Single — одногоранговая), D (Dual — двухранговая), Q (Quad — четырехранговая).

Пример полной расшифровки маркировки на модулях Kingston:

Серверные материнские платы ограничены суммарным числом рангов памяти, с которыми могут работать. Например, если максимально может быть установлено восемь рангов при уже установленных четырех двухранговых модулях, то в свободные слоты память добавить не получится.

Перед покупкой модулей есть смысл уточнить, какие типы памяти поддерживает процессор сервера. Например, Xeon E5/E5 v2 поддерживают одно-, двух- и четырехранговые регистровые модули DIMM (RDIMM), LRDIMM и не буферизированные ECC DIMM (ECC UDIMM) DDR3. А процессоры Xeon E5 v3 поддерживают одно- и двухранговые регистровые модули DIMM, а также LRDIMM DDR4.

Немного про скучные аббревиатуры таймингов

Тайминги или латентность памяти (CAS Latency, CL) — величина задержки в тактах от поступления команды до ее исполнения. Числа таймингов указывают параметры следующих операций:

CL (CAS Latency) – время, которое проходит между запросом процессора некоторых данных из памяти и моментом выдачи этих данных памятью;

tRCD (задержка от RAS до CAS) – время, которое должно пройти с момента обращения к строке матрицы (RAS) до обращения к столбцу матрицы (CAS) с нужными данными;

tRP (RAS Precharge) – интервал от закрытия доступа к одной строке матрицы, и до начала доступа к другой;

tRAS – пауза для возврата памяти в состояние ожидания следующего запроса;

Разумеется, чем меньше тайминги – тем лучше для скорости. Но за низкую латентность придется заплатить тактовой частотой: чем ниже тайминги, тем меньше допустимая для памяти тактовая частота. Поэтому правильным выбором будет «золотая середина».

Существуют и специальные более дорогие модули с пометкой «Low Latency», которые могут работать на более высокой частоте при низких таймингах. При расширении памяти желательно подбирать модули с таймингами, аналогичными уже установленным.

RAID для оперативной памяти

Ошибки при хранении данных в оперативной памяти неизбежны. Они классифицируются как аппаратные отказы и нерегулярные ошибки (сбои). Память с контролем четности способна обнаружить ошибку, но не способна ее исправить.

Для коррекции нерегулярных ошибок применяется ECC-память, которая содержит дополнительную микросхему для обнаружения и исправления ошибок в отдельных битах.

Метод коррекции ошибок работает следующим образом:

При записи 64 бит данных в ячейку памяти происходит подсчет контрольной суммы, составляющей 8 бит.

Когда процессор считывает данные, то выполняется расчет контрольной суммы полученных данных и сравнение с исходным значением. Если суммы не совпадают – это ошибка.

Технология Advanced ECC способна исправлять многобитовые ошибки в одной микросхеме, и с ней возможно восстановление данных даже при отказе всего модуля DRAM.

Исправление ошибок нужно отдельно включить в BIOS

Большинство серверных модулей памяти являются регистровыми (буферизованными) – они содержат регистры контроля передачи данных.

Регистры также позволяют устанавливать большие объемы памяти, но из-за них образуются дополнительные задержки в работе. Дело в том, что каждое чтение и запись буферизуются в регистре на один такт, прежде чем попадут с шины памяти в чип DRAM, поэтому регистровая память оказывается медленнее не регистровой на один такт.

Все регистровые модули и память с полной буферизацией также поддерживают ECC, а вот обратное не всегда справедливо. Из соображений надежности для сервера лучше использовать регистровую память.

Многопроцессорные системы и память

Для правильной и быстрой работы нескольких процессоров, нужно каждому из них выделить свой банк памяти для доступа «напрямую». Об организации этих банков в конкретном сервере лучше почитать в документации, но общее правило такое: память распределяем между банками поровну и в каждый ставим модули одного типа.

Если пришлось поставить в сервер модули с меньшей частотой, чем требуется материнской плате – нужно включить в BIOS дополнительные циклы ожидания при работе процессора с памятью.

Для автоматического учета всех правил и рекомендаций по установке модулей можно использовать специальные утилиты от вендора. Например, у HP есть Online DDR4 (DDR3) Memory Configuration Tool.

Итого

Вместо пространственного заключения приведу общие рекомендации по выбору памяти:

Для многопроцессорных серверов HP рекомендуется использовать только регистровую память c функцией коррекции ошибок (ECC RDIMM), а для однопроцессорных — небуферизированную с ECC (UDIMM). Планки UDIMM для серверов HP лучше выбирать от этого же производителя, чтобы избежать самопроизвольных перезагрузок.

В случае с RDIMM лучше выбирать одно- и двухранговые модули (1rx4, 2rx4). Для оптимальной производительности используйте двухранговые модули памяти в конфигурациях 1 или 2 DIMM на канал. Создание конфигурации из 3 DIMM с установкой модулей в третий банк памяти значительно снижает производительность.

Список короткий, но здесь все самое необходимое и наименее очевидное. Конечно же, старый как мир принцип RTFM никто не отменял.

UDIMM и DIMM виды оперативной памяти и их различия

Что такое оперативная память? Это так называемая временная память вашего компьютера в которую на протяжении всего времени, что вы работаете за компьютером загружаются запускаемые вами программы, приложения и данные. Эта память которая позволяет вашей операционной системе Windows загружаться, а также загружать ваш антивирус и Skype и производить разного рода вычисления, играть в игры, смотреть фильмы, серфить по интернету и т.д. и т.п.

Однако если вы хоть раз собирали себе компьютер, то наверняка сталкивались с тем, что существует множество типов оперативной памяти. Одними из таких типов памяти, являются UDIMM и DIMM. Разного рода типы оперативной памяти зависят от материнской платы и от конструкции слота, куда эта самая память будет установлена.

Перед тем как покупать себе оперативную память вы должны не только выбрать ее значение Гб, но также понять какой конкретно тип памяти вам необходим, иначе вы столкнетесь с тем, что ваша планка памяти не просто откажется работать с вашим железом, но и попросту не станет в предназначенный для нее модуль в материнской плате.

Итак, чем же отличаются друг от друга виды памяти UDIMM и DIMM?

UDIMM память часто используется в домашних компьютерах и является небуферизованной памятью. Данный вид памяти менее стабилен, но является боле быстрый и дешевый. Хотя если тип памяти именуемый RDIMM применяется в тех системах, где любая нестабильность может оказаться крахом для вас, UDIMM все же более эффективная память с точки зрения стабильности ее работы. UDIMM память можно рекомендовать к использованию в домашних компьютерах, либо офисной технике, которая не требует большой технической оснастки… Впрочем, UDIMM уже устаревший вид памяти который себя изжил. Главная проблема этого типа памяти — это отсутствие физического буфера. Другими словами, как только возникает ошибка, у вас сразу же возникают проблемы с компьютером.

Теперь самый передовой вид памяти это DIMM. DIMM — это современный тип памяти, последняя разработка так сказать. DIMM называют двухсторонней памятью, видимо в виду того, что ее чипсеты паяют с двух сторон платы, а не с одной как в случае с памятью типа UDIMM.

UDIMM память сейчас используется как в настольных компьютерах, так и в ноутбуках и мобильных устройствах, таких как смартфоны и планшеты.

Очень важно! Несмотря на то, что вид этих двух типов планок абсолютно одинаковый, нельзя установить на материнскую плату две разного типа планки. Ваш компьютер не будет работать вовсе, либо не будет работать корректно. Для корректной работы необходимо устанавливать планки с одинаковыми характеристиками.

Для полного понимания вопроса по оперативной памяти, приведем в качестве примера спецификацию планок оперативной памяти, чтобы наглядно все показать.

DDR2 (Double Data Rate 2) SDRAM

DDR2 400 MHz или PC2-3200

DDR2 533 MHz или PC2-4200

DDR2 667 MHz или PC2-5400

DDR2 800 MHz или PC2-6400

DDR2 900 MHz или PC2-7200

DDR2 1000 MHz или PC2-8000

DDR2 1066 MHz или PC2-8500

DDR2 1150 MHz или PC2-9200

DDR2 1200 MHz или PC2-9600

DDR3 (Double Data Rate 3) SDRAM

DDR3 1066 MHz или PC3-8500

DDR3 1333 MHz или PC3-10600/10666

DDR3 1375 MHz или PC3-11000

DDR3 1600 MHz или PC3-12800

DDR3 1625 MHz или PC3-13000

DDR3 1800 MHz или PC3-14400

DDR3 1866 MHz или PC3-15000

DDR3 2000 MHz или PC3-16000

Сегодня мы познакомили вас с двумя видами оперативной памяти. Теперь вам понятно, чем они отличаются и в том случае если вы хотели купить себе планки оперативной памяти, вы знаете что выбрать и знаете, что нельзя использовать два разных вида на одной материнской плате!

Технологии

В настоящее время, имеют распространение следующие технологии организации оперативной памяти:

UDIMM (англ. Unbuffered DIMM) – небуферизованная память. Обычные планки ОЗУ, которые устанавливаются в персональных компьютерах и некоторых серверах начального уровня. Поддерживается установка до двух планок памяти на канал. Как правило, память типа UDIMM поддерживает технологию автоматической коррекции ошибок ECC, а объем одной планки составляет не более 16 ГБ.

RDIMM (англ. Registered DIMM) – регистровая память. Планки ОЗУ, широко применяющиеся в серверах. Снабжены специальным регистром, который буферизует управляющие и адресные команды контроллера памяти. Благодаря этому, снижается нагрузка на контроллер и появляется возможность использовать более объемные планки памяти и в большем количестве в рамках одного сервера. Объем планки типа RDIMM может достигать 32 ГБ.

LRDIMM (англ. Load-Reduced DIMM) – память со сниженной нагрузкой. Еще один тип ОЗУ с механизмом буферизации. В отличие от RDIMM, здесь в буфер отправляются не только управляющие и адресные команды, но и собственно данные. Эта технология позволяет значительно снизить нагрузку на контроллер памяти и использовать планки емкостью до 128 ГБ. Кроме того, в отличие от RDIMM, при использовании более двух планок LRDIMM на канал не снижается скорость работы памяти.

NVDIMM (англ. Non-Volatile DIMM) – энергонезависимая память. Технология организации ОЗУ с возможностью сохранения загруженных в память данных при штатном либо аварийном завершении работы системы. Память типа NVDIMM может использовать емкости флэш-накопителей (например, SSD) в качестве энергонезависимого хранилища, либо иметь специальный резервный модуль энергонезависимой флэш-памяти, в который будут переписываться данные при завершении работы.

Комбинировать память UDIMM, RDIMM и LRDIMM в рамках одного сервера не допускается. Требования к NVDIMM могут быть разными у разных производителей. Компания HPE в рамках новой серии Persistent Memory анонсировала планки NVDIMM на 8 ГБ для серверов DL360 Gen.9 и DL380 Gen.9. Для одного сервера допускается установка до 16 планок NVDIMM и имеется возможность совмещать их с RDIMM. При использовании HPE NVDIMM требуются процессоры Intel Xeon E5-2600 v4, наличие батареи поддержки кэш-памяти HPE Smart Storage Battery (в качестве источника питания при перезаписи данных в энергонезависимый модуль) и как минимум одной планки RDIMM.

Репликация – процесс передачи данных с одного устройства хранения на другие с целью создания резервной копии этих данных, обеспечения сценариев высокой доступности или катастрофоустойчивости. Существует 2 типа репликации: синхронная и асинхронная.

В системах хранения компании HPE имеются следующие решения по репликации:

При организации репликации для систем хранения обычно оперируют двумя показателями.

Recovery Point Objective (RPO) – допустимый объем возможных потерь данных в случае сбоя (потерю данных за какой промежуток времени мы можем допустить). Измеряется в секундах.

Recovery Time Objective (RTO) – допустимое время простоя системы в случае сбоя. Измеряется в секундах.

В случае с синхронной репликацией значение RPO стремится к 0, но зато предъявляются более высокие требования к каналам связи.

В случае с асинхронной репликацией значение RPO будет не 0. В системах хранения HPE, как правило, значение варьируется от 5 минут до 24 часов.

Тиринг (англ. Tiering) – это технология, с помощью которой СХД может самостоятельно перераспределять данные по накопителям на основе частоты их использования. Редко используемые данные перемещаются на более медленные накопители, а часто используемые – на более быстрые.

Тиринг дает возможность сэкономить на дорогих HDD или SSD, позволяя приобрести их в небольшом количестве и использовать более дешевые и объемные NLSAS/SATA для хранения основных данных, которые не используются в текущий момент. Согласно статистическим показателям, до 70% данных располагается на медленных дисках при использовании тиринга.

Как правило, в СХД выделяется 3 уровня или «тира» (от англ. Tier):

На большинстве современных СХД тиринг работает в автоматическом режиме. Система самостоятельно анализирует частоту обращений к различным блокам данных того или иного LUN и перемещает их между уровнями хранения. Данный режим называется sub-LUN tiering. У HPE в некоторых СХД для него принято название Adaptive Optimization. Некоторое время назад был распространен ручной режим тиринга, когда система могла осуществить перенос только всего LUN и только по команде администратора. Этот функционал у HPE носит название Dynamic Optimization.

Сегодня тиринг реализован на всех основных SAN СХД компании HPE: MSA, StoreVirtual, 3PAR. Для его активации может потребоваться приобретение дополнительной лицензии.

Virtual Tier Affinity – дополнительное улучшение для тиринга в массивах HPE MSA, приоритизация данных на уровне LUN (механизм «Quality of Service»). Администратор может выставить для каждого LUN высокий, либо низкий приоритет. В первом случае данные LUN быстрее станут попадать на самый производительный уровень хранения и дольше там находиться. Во втором случае данные по умолчанию будут записываться на архивный (наименее производительный) уровень и быстрее туда опускаться в случае последующего поднятия.

Дедупликация – это технология, которая позволяет находить и исключать одинаковые (дублирующиеся) данные в рамках системы хранения с целью экономии дисковых объемов. С включенной дедупликацией одинаковые данные не будут записываться на накопители при последующих циклах записи, а будет записываться лишь ссылка на те данные, что уже записаны. Дедупликация бывает файловая и аппаратная.

В случае с файловой дедупликацией, операционная система отслеживает полностью идентичные файлы и хранит только одну копию этих файлов. Например, когда сотрудник внутри организации делает рассылку с вложением, на почтовом сервере Exchange это вложение сохраняется в единственном экземпляре. Получатели данного письма при открытии вложения просто перейдут по ссылке на этот файл.

Аппаратная дедупликация работает не на уровне идентичных файлов, а на уровне блоков данных. В этом случае, проверкой блоков занимается не операционная система, а контроллер системы хранения.

В системах хранения HPE дедупликация реализована для следующих моделей:

Компрессия (сжатие данных) – еще одна технология, позволяющая экономить объемы хранилища путем уменьшения размеров хранимых данных. В отличие от дедупликации, она не исключает копии, а посредством различных алгоритмов уменьшает размер (производит сжатие) имеющихся данных.

Как и дедупликация, компрессия бывает файловая и аппаратная.

При файловой компрессии, операционная система или специальное ПО пытается найти избыточные фрагменты в составе каждого файла и удалить их, что приведет к уменьшению его общего размера. Например, для текстового файла могут быть убраны ненужные пробелы в конце, а повторяющиеся слова или символы заменены особым, более компактным кодированием. Для изображений удаляются избыточные пиксели, в аудиофайлах исключаются малозаметные для слуха звуковые эффекты.

При аппаратной компрессии происходит сжатие блоков данных по специальным алгоритмам. Аппаратную компрессию выполняет контроллер системы хранения.

Процесс компрессии может происходить с потерями (англ. lossy), либо без потерь (англ. lossless). В первом случае исходные данные уже не могут быть полноценно восстановлены из сжатых данных. Такие результаты допустимы при сжатии изображений или аудио, где небольшое снижение качества является приемлемым. Во втором случае возможность восстановления предусматривается, что является предпочтительным для корпоративных СХД, хранящих важные данные.

Как правило, в системах хранения, поддерживающих и дедупликацию и компрессию, для оптимального использования вычислительных ресурсов вначале выполняется дедупликация, а затем – компрессия, которая затрагивает только оставшиеся данные и не применяется к тем данным, которые все равно будут удалены дедупликацией.

В системах хранения HPE реализация аппаратной компрессии в ближайшем будущем предполагается для 3PAR StoreServ.

Дедупликация и компрессия могут происходить в режиме реального времени (англ. inline), либо в режиме последующей обработки (англ. post-process). В первом случае данные подвергаются обработке, еще находясь в памяти, и уже затем записываются на накопители. Этот метод обеспечивает экономию места и меньшую нагрузку на дисковую подсистему, однако нагрузка на вычислительные ресурсы является существенной. Во втором случае данные записываются на накопители без изменений, а затем подвергаются дедупликации или компрессии согласно установленному расписанию. Это обеспечивает экономию вычислительных ресурсов и в некоторых случаях ускоряет первоначальную запись данных, однако требует больше места на дисках.

Важно отметить, что эффективность дедупликации и компрессии напрямую зависит от состава и структуры конкретных данных, к которым планируется применять указанные технологии. К примеру, для компрессии хорошо подходят транзакционные БД, где в рамках каждого экземпляра базы часто встречаются повторяющиеся последовательности данных. Дедупликация результативна в средах виртуализации и VDI, в которых попадается множество очень похожих файлов виртуальных машин. В некоторых же случаях, положительного эффекта от дедупликации и компрессии может не быть вовсе или он будет минимальным.

Количественным показателем эффективности указанных технологий в каждом конкретном случае является коэффициент дедупликации или компрессии, который записывается в формате A:B. Данное выражение показывает отношение объема, который должен был быть занят на СХД без учета действия технологий (значение A), к тому объему, который оказался реально занят после применения дедупликации или компрессии (значение B). Например, при коэффициенте дедупликации 2:1 данные, имеющие объем 2 ТБ, после применения технологии займут на СХД в 2 раза меньше места – лишь 1 ТБ.

Сетевой RAID по принципу своей работы аналогичен классическому RAID, только его элементами являются не отдельные диски, а отдельные контроллеры. Тома (LUN) обслуживаются всеми участвующими контроллерами, при этом уровень сетевого RAID мы можем задавать на уровне конкретного тома. К примеру, в рамках одного кластера для первого тома мы можем настроить сетевой RAID 10, а для второго – сетевой RAID 0. После этого, блоки данных в указанных томах будут записываться и распределяться соответственно уровню сетевого RAID.

В настоящее время, для SV3200 доступны следующие уровни сетевого RAID: 0, 10. Уровень 0 представляет собой обычное чередование записываемых блоков данных между контроллерами, и может быть реализован как в кластере, так и для единственной SV3200 (для двух ее контролеров). В случае сетевого RAID 10 при записи данных происходит чередование записываемых блоков между двумя контроллерами одной, а затем зеркалирование записанных данных на другую СХД. Данные уровни в сетевом RAID работают точно так же, как и в обычном (см. рисунок).

В 10м поколении серверов ProLiant HPE реализовал новые, не использовавшиеся ранее технологии. Это позволило улучшить показатели производительности, надежности и безопасности серверов.

Из основных усовершенствований стоит выделить:

HPE Nimble Storage – семейство систем хранения данных. Отличительные черты этих СХД – частичное (наряду с HDD), либо полное (all-flash) использование SSD накопителей во всех моделях, а также очень высокий уровень надежности. HPE заявляет о доступности Nimble Storage в 99,9999%, что достигается благодаря применению платформы облачной аналитики InfoSight. Относительно недавно была добавлена поддержка линейки продуктов HPE 3PAR в InfoSight.

Данная технология позволяет СХД непрерывно в автоматическом режиме собирать большое количество данных как о собственном состоянии, так и об окружающей инфраструктуре (подключенные сети, серверы, платформы виртуализации). Затем эти показатели отправляются в облачную систему, где с помощью сложных аналитических алгоритмов выявляются текущие проблемы и делаются прогнозы о будущем состоянии инфраструктуры. На основе данных выводов заказчику предоставляются автоматические исправления и рекомендации для администратора СХД. Например, при обнаружении у одного из клиентов проблемы в совместимости микропрограммы контроллеров СХД с приложениями гипервизора система автоматически заблокирует возможность установки данной версии прошивки на СХД у других клиентов, а тем у кого уже установлена схожая конфигурация будет предложен критический апдейт системы.

Такой подход помогает предотвращать сбои до их возникновения, причем во многих случаях без вмешательства администратора. По данным вендора, при использовании InfoSight 86% проблем разрешаются без участия ИТ-службы. Сюда входят инциденты как с самой СХД, так и с окружающей инфраструктурой. Причем по данным HPE, более половины проблем, как правило, не связаны с СХД.

InfoSight позволяет значительно сократить время на поиск проблемных узлов инфраструктуры в случае деградации производительности. Система в удобном графическом виде показывает текущее время отклика и статистику задержек за определенный период по проблемной ВМ не только относительно самой СХД, но и сети передачи данных SAN, а также приложений гипервизора. Отклонение каких-либо показателей в кратчайшие сроки позволит определить «узкое место» инфраструктуры. Не нужно переключаться между несколькими системами мониторинга, все показатели доступны в едином портале, так как InfoSight интегрируется с VmWare VCenter.

Благодаря оценке статистической информации сразу по большому количеству СХД, система позволяет провести более точный сайзинг инфраструктуры, чем это бы делалось в любом оффлайн-сайзере. Тем самым становится возможно более точно строить планы апргрейда, сократив, возможно излишние затраты на покупку ненужных компонентов.

Облачная система InfoSight является единой для заказчиков Nimble Storage по всему миру. Она использует общие базы и машинное обучение на основе уже имеющихся данных для постоянного совершенствования своих прогнозов. Собранные данные хранятся на вычислительных мощностях InfoSight в США.

В процессе диагностики собирается только служебная информация, собственные данные заказчика не затрагиваются.

Информация передается по защищенному SSL каналу. Некоторые примеры передаваемых данных:

Иногда, для устранения определенных проблем требуется снятие содержимого памяти контроллера (core data dump). В полученный снимок могут попасть некоторые пользовательские данные. В такой ситуации заказчик по своему желанию может разрешить передачу снимка в поддержку Nimble Storage. Передача не является обязательной, однако без нее возможности специалистов поддержки по работе над проблемой будут ограничены.

В случае своего согласия, заказчик оформляет письменное разрешение, отправляет его в поддержку Nimble и инициирует передачу снимка. Передача происходит по SSL каналу. HPE обязуется принять все необходимые технические меры для защиты конфиденциальности полученных данных заказчика, такие как контроль и аудит доступа персонала к данным, закрытие внешнего доступа через ACL, антивирусная защита, физическая защита серверных комнат и т.д.

Подключение СХД Nimble Storage к InfoSight осуществляется через сеть управления. Заказчик должен будет открыть следующие порты для исходящего трафика (никаких входящих соединений не требуется):

Технология HPE SmartCache позволяет использовать SSD накопители в качестве дополнительной кэш-памяти. Данное решение применяется в среде DAS (внутренние накопители сервера, либо локально подключенные DAS полки).

SmartCache работает как на чтение, так и на запись. При операциях чтения часто запрашиваемые данные помещаются в кэш из SSD накопителей. Операции записи происходят вначале на SSD-кэш, а затем данные перемещаются на HDD. Благодаря тому, что SSD по сравнению с HDD имеют значительно более высокую производительность, увеличивается скорость работы приложений (по данным HPE – до 4 раз).

SmartCache доступна с контроллерами Smart Array P-класса, которые имеют кэш типа FBWC емкостью не менее 1 Гбайт. Технология может использоваться на серверах 8го и более новых поколений. Настройка производится через средство управления контроллерами Smart Array – HPE Smart Storage Administrator.

SmartCache имеет собственную лицензию, при этом для некоторых контроллеров (например, P816i-a SR Gen.10) она включается по умолчанию, а для других требуется приобретать ее отдельно.

Схема работы файловой системы Nimble Storage

Схема работы Triple+ Parity RAID

В настоящее время, для подключения накопителей в персональных компьютерах, серверах и системах хранения наиболее часто используются 2 интерфейса: SAS и SATA. SAS (англ. Serial Attached SCSI) является преемником параллельной технологии SCSI (англ. Small Computer System Interface). SATA (англ. Serial ATA) – преемник параллельного интерфейса ATA (англ. Advanced Technology Attachment).

В отличие от своих предшественников, протоколы SAS и SATA предусматривают последовательную передачу данных, то есть вся информация передается единым потоком (в параллельных технологиях задействуется множество потоков). Последовательная передача данных позволяет достичь гораздо более высоких скоростей, чем параллельная. Кроме того, в протоколах SAS и SATA используется тип соединения «точка-точка» между контроллером и оконечным устройством, то есть каждый накопитель имеет полную полосу пропускания. В случае SCSI полоса пропускания общая, и она делится между всеми подключенными устройствами.

SAS по сравнению с SATA предоставляет более высокую пропускную способность и расширенную функциональность, а потому накопители на его основе чаще используются в серверах и системах хранения корпоративного класса. SATA, с другой стороны, имеет более низкую стоимость и применяется в большинстве персональных компьютеров, серверов и систем хранения начального уровня. Основные различия между протоколами:

| SATA | SAS | |

| Пропускная способность | 6 Гбит/с (SATA III) | 12 Гбит/с (SAS-3) ) |

| Набор команд | ATA | SCSI |

| Порты | 1 полудуплексный* | 2 полнодуплексных* |

| Глубина очереди | До 32 команд | До 254 команд |

| Длина кабелей | До 1 м (2 м для eSATA**) | До 10 м |

| Возможности расширения | До 15 устройств на 1 порт с использованием SATA мультипликатора | Более 65 тыс. устройств на 1 порт с использованием SAS расширителей |

| Обратная совместимость | SATA контроллер не поддерживает SAS накопители | SAS контроллер поддерживает SATA накопители |

| Дополнительные функции | Нет | Технология Multipath I/O, позволяющая подключать накопитель по 2 каналам (через 2 порта) и осуществлять резервирование путей / балансировку нагрузки Технология проверки контрольных сумм T.10 при записи данных Технология зонинга T.10, позволяющая разбить домен SAS на зоны для удобства настройки и управления (по аналогии с VLAN) |

* полудуплексный режим работы – возможность в определенный момент времени вести только прием, либо только передачу; полнодуплексный – возможность вести прием и передачу одновременно

** eSATA – англ. External SATA, интерфейс SATA для подключения внешних устройств

Общий обзор технологий и программных функций массивов HPE 3PAR StoreServ:

* КиБ – кибибайт, 1 КиБ равен 1024 байт

** Емкость динамически выделяется только под фактически записываемые данные

Функционал репликации в массивах HPE 3PAR StoreServ носит название Remote Copy (RC). Поддерживаются следующие режимы репликации:

При асинхронном периодическом режиме для репликации используются мгновенные снимки (снапшоты) томов (LUN), создаваемые через заданный интервал времени. На удаленный массив передаются только новые блоки данных, содержащиеся в снимке по сравнению с предыдущим снимком. При асинхронном потоковом режиме новые блоки накапливаются в локальном массиве в течение небольшого периода времени и затем реплицируются на удаленный массив.

С точки зрения среды передачи для репликации поддерживаются следующие варианты:

С точки зрения схем, по которым происходит репликация (топологий) поддерживаются следующие варианты:

Схема репликации Многие-ко-многим для 4 массивов. Каждый массив реплицирует данные на 4 других массива.

Схема репликации SLD

Репликация по указанным схемам может происходить между любыми моделями массивов 3PAR. Например, в рамках одной топологии можно использовать 3PAR 8200, 8450, 20850.

Технология NPAR реализована на некоторых сетевых адаптерах для серверов HPE. Она позволяет разделить пропускную способность порта адаптера на 4 независимые партиции (физические PCI функции). Каждой физической функции назначается собственная полоса пропускания так, чтобы суммарная пропускная способность четырех партиций не превышала пропускную способность того порта, на котором они настроены. К примеру, для порта 10 Гбит/с можно создать партиции 5 Гбит/с, 2 Гбит/с, 1 Гбит/с и 2 Гбит/с.

Для ОС сервера и для подключенного сетевого оборудования каждая физическая функция представляется как отдельный физический порт. Технология NPAR обеспечивает более эффективное использование пропускной способности адаптеров, позволяя задействовать имеющуюся полосу пропускания для большего количества задач. В частности, это актуально в средах VMware, где рекомендуется использовать несколько физических портов под разные типы трафика (Service Console, VMkernel, VM Network).

NVMe (англ. Non-Volatile Memory Express) – протокол передачи данных для SSD накопителей, подразумевающий непосредственное подключение накопителя к шине PCIe*. Данный стандарт был разработан с целью преодоления ограничений, присущих интерфейсам SATA и SAS, которые ориентированы на работу с HDD и зачастую не позволяют раскрыть потенциал производительности SSD. Вследствие недостаточной пропускной способности и глубины очереди традиционные интерфейсы могут стать «узким местом» и причиной задержек между мощными вычислительными ресурсами и построенной на SSD подсистемой хранения.

Пропускная способность интерфейса NVMe зависит от количества используемых линий PCIe. Максимально может использоваться 16 линий, и при полосе пропускания 1 Гбит на линию для PCIe 3.0 пропускная способность интерфейса будет составлять 16 Гбит (против 6 Гбит для SATA и 12 Гбит для SAS). Кроме того, NVMe предусматривает одновременную организацию нескольких (до 65 000) очередей с глубиной до 65 000 команд (в отличие от SATA и SAS, где очередь только одна с 32 и 254 командами соответственно).

SSD накопители, работающие по протоколу NVMe, имеют несколько возможных форм-факторов и способов подключения. Во-первых, они могут быть выполнены в формате PCIe карты расширения и устанавливаться в стандартный слот PCIe.

NVMe SSD накопитель в формате карты расширения PCIe

Во-вторых, они могут иметь формат карты M.2 и устанавливаться в специальный слот M.2.

NVMe SSD накопитель в формате M.2

Разъем под M.2 NVMe SSD

В-третьих, они могут иметь форм-фактор SFF накопителя, устанавливаться в SFF корзину для накопителей и подключаться к райзер-плате PCIe (данный формат называется U.2).

NVMe SSD накопитель размером SFF в формате U.2

* PCIe (англ. Peripheral Component Interconnect Express) – высокоскоростная шина с последовательной передачей данных, используемая для подключения компонентов расширения к материнской плате.

Storage Class Memory (память класса хранилища) – семейство технологий энергонезависимой памяти. К Storage Class Memory (SCM) относятся такие технологии, как магниторезистивная оперативная память (англ. Magnetoresistive Random-Access Memory, MRAM), резистивная память с произвольным доступом (англ. Resistive RAM, ReRAM), память на основе фазового перехода (англ. Phase Change Memory, PCM), 3D XPoint от Intel и Micron.

По производительности SCM в несколько раз превосходит стандартные SSD накопители и приближается к оперативной памяти (DRAM). Принципы ее архитектуры отличаются от принятых в классических SSD (NAND), благодаря чему SCM обеспечивает гораздо более низкие задержки и высокую износостойкость. Стоимость SCM решений выше, чем у обычных NAND SSD, но ниже, чем у оперативной памяти DRAM. Предполагается, что SCM устройства смогут устанавливаться в слоты для оперативной памяти DDR4, либо в слоты расширения PCIe и M.2. Во втором случае они будут работать по протоколу NVMe.

В настоящее время, различные производители работают над развитием и продвижением технологий SCM. Примерами конкретных реализаций служат мемристоры HPE, накопители Intel Optane (на основе технологии 3D XPoint), Micron QuantX (на основе технологии 3D XPoint) и Samsung Z-SSD.

SCM решения могут использоваться для размещения наиболее критичных нагрузок в серверах, а также в качестве самого быстрого или кэширующего уровня в системах хранения. Последний подход был реализован HPE в СХД 3PAR StoreServ путем установки в контроллеры массива SSD Intel Optane. По результатам внутренних тестов вендора, это привело к снижению задержек на 50% и увеличению производительности в IOPS на 80% (использовалась двухконтроллерная модель 3PAR 20450 с восемью SSD 15,36 ТБ и одним Intel Optane в каждом контроллере). Данное решение получило название 3PAR 3D Cache. Ожидается, что коммерчески доступным оно станет после того, как Intel наладит производство и поставку SSD Optane в широких масштабах.

.jpg)